GLM-4.7, новейшая большая языковая модель с открытым исходным кодом от Zhipu AI, официально выпущена, предлагая существенные улучшения в области программирования, рассуждений и выполнения задач с использованием агентов. Релиз укрепляет позиции GLM как одной из самых мощных моделей с открытым исходным кодом для реальной разработки программного обеспечения и рабочих процессов, управляемых инструментами.

Улучшенные возможности кодирования и работы с агентами

GLM-4.7 представляет значительные улучшения в производительности программирования, особенно в многоязычном кодировании и рабочих процессах агентов на основе терминала. Модель теперь поддерживает надежный механизм «думай, прежде чем действовать» в популярных фреймворках кодирования, таких как Claude Code, TRAE, Kilo Code, Cline и Roo Code, что обеспечивает большую стабильность при выполнении сложных многошаговых задач.

Ключевые улучшения включают:

- Расширенные возможности кодирования: более надежная генерация и выполнение кода на различных языках и в разных средах.

- Улучшенная эстетика фронтенда: более качественная генерация веб-страниц, слайдов и плакатов с лучшей компоновкой, визуальным балансом и согласованностью дизайна.

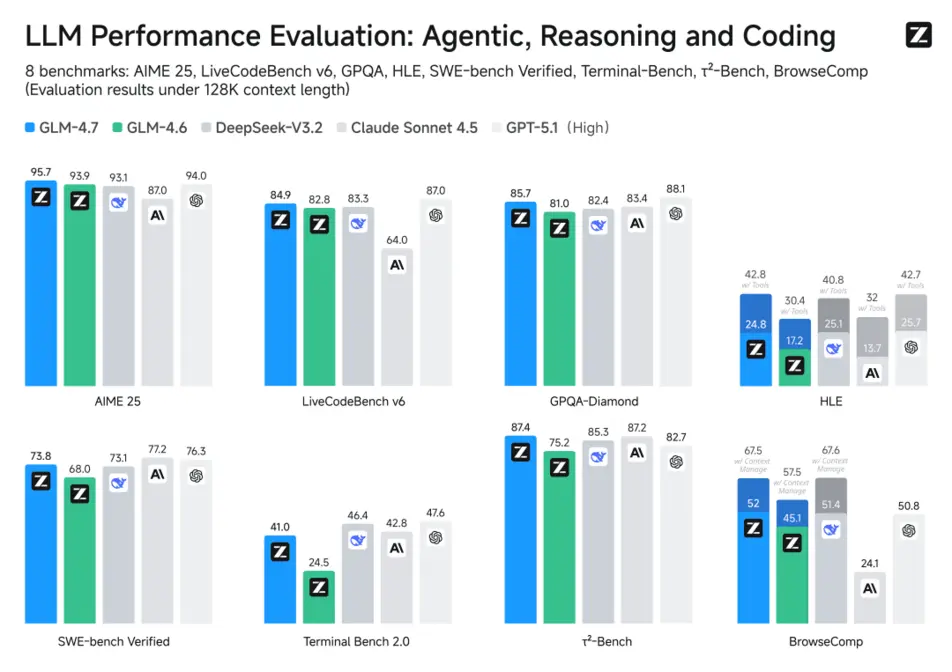

- Улучшенное использование инструментов: GLM-4.7 получила 67,5 баллов в бенчмарке веб-задач BrowseComp и 87,4 балла в τ²-Bench для интерактивного использования инструментов, установив новый стандарт для открытых моделей и превзойдя Claude Sonnet 4.5.

- Улучшенные рассуждения: в бенчмарке HLE («Последний экзамен человечества») GLM-4.7 достигла 42,8%, что на 41% лучше, чем у GLM-4.6, и превосходит GPT-5.1.

- Более естественный общий интеллект: диалоги стали более лаконичными и похожими на человеческие, с заметным улучшением качества письма и погружения в ролевые игры.

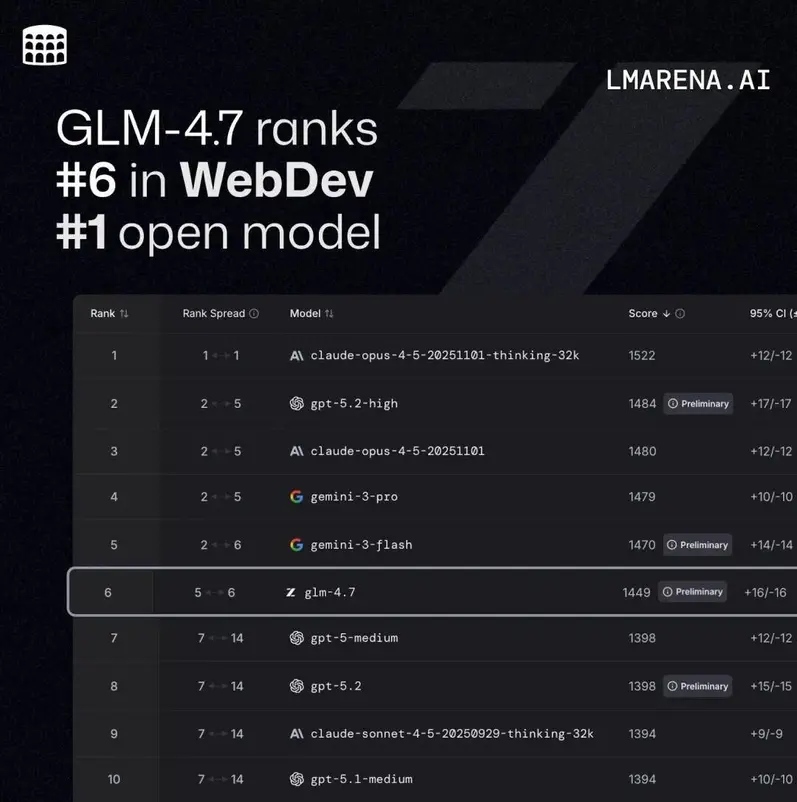

В Code Arena, платформе слепого тестирования кода с более чем миллионом участников по всему миру, GLM-4.7 занимает первое место среди моделей с открытым исходным кодом и первое место среди китайских моделей, опережая GPT-5.2.

Результаты бенчмарков: конкурентоспособность с ведущими закрытыми моделями

В стандартных бенчмарках GLM-4.7 показывает результаты, близкие к Claude Sonnet 4.5, в области программирования:

- SWE-bench-Verified: 73,8% (SOTA с открытым исходным кодом)

- LiveCodeBench v6: 84,9% (SOTA с открытым исходным кодом, превосходит Claude Sonnet 4.5)

- SWE-bench Multilingual: 66,7% (+12,9%)

- Terminal Bench 2.0: 41% (+16,5%)

Ощутимые преимущества в реальной разработке

1.1 Реальные задачи программирования

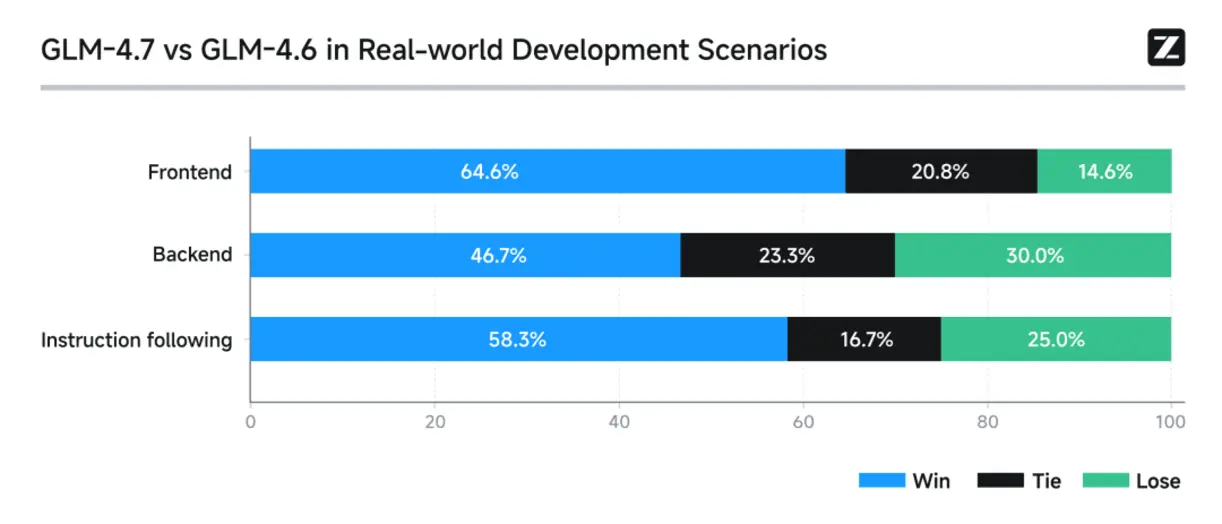

В тестах, включающих 100 реальных задач программирования в среде Claude Code, охватывающих фронтенд, бэкенд и следование инструкциям, GLM-4.7 продемонстрировала явные улучшения по сравнению с GLM-4.6 как в стабильности, так и в результативности. Теперь разработчики могут организовывать рабочие процессы, ориентированные на полное выполнение задач от начала до конца, от понимания требований до получения готового к производству результата.

1.2 Развитие управляемых рассуждений

GLM-4.7 расширяет свою систему рассуждений тремя режимами:

- Чередующееся мышление: модель рассуждает перед каждым ответом или вызовом инструмента, улучшая соблюдение инструкций и качество кода.

- Сохраняемое мышление: блоки рассуждений сохраняются на протяжении многоходовых разговоров, повышая эффективность кэширования и снижая затраты на длительные задачи.

- Контроль мышления на уровне хода: разработчики могут регулировать глубину рассуждений для каждого хода — отключая ее для простых запросов, чтобы уменьшить задержку, или включая ее для сложных задач, чтобы повысить точность.

1.3 Выполнение сложных задач

Модель демонстрирует более сильную декомпозицию задач и интеграцию технологических стеков, часто создавая полные, исполняемые проекты за один проход, с четкими инструкциями по зависимостям и выполнению. Примеры включают полностью сгенерированные интерактивные игры, такие как игры в стиле Plants vs. Zombies и Fruit Ninja.

1.4 Дизайн фронтенда и визуальный вывод

GLM-4.7 демонстрирует более глубокое понимание визуального кода и соглашений пользовательского интерфейса. Стандартные выходные данные отличаются улучшенной структурой макета, цветовой гармонией и стилизацией компонентов, что снижает необходимость ручной визуальной доводки. В сценариях офисной продуктивности точность компоновки PPT 16:9 выросла с 52% до 91%, что сделало выходные данные в значительной степени «готовыми к использованию».

План кодирования GLM обновлен с учетом GLM-4.7

План кодирования GLM был обновлен, чтобы включить GLM-4.7, предлагая оптимизированный баланс производительности, скорости и стоимости:

- Полная поддержка рассуждений в Claude Code для стабильного многошагового выполнения

- Целевые оптимизации для рабочих процессов Skills, Subagents и Claude.md

- Встроенное визуальное понимание, поиск и чтение веб-страниц для сквозного кодирования

- Улучшенный дизайн архитектуры и следование инструкциям, снижение галлюцинаций в сценариях с длинным контекстом

В рамках запуска все платные пользователи получают опытный пропуск, позволяющий 3–7 приглашенным пользователям получить 7-дневную бесплатную пробную версию.

Широкое внедрение разработчиками и поддержка экосистемы

Глобальные платформы для разработчиков сообщают о сильных результатах:

- TRAE отметил улучшенную стабильность и доступность GLM-4.7 в своей китайской версии.

- Cerebras отметил, что GLM-4.6 достигла скорости до 1000 токенов в секунду на своем оборудовании, обеспечивая один из самых быстрых опытов кодирования.

- YouWare сообщил о значительном улучшении качества дизайна фронтенда, завершения сложных функций, параллелизма инструментов и соблюдения инструкций.

Дополнительные положительные отзывы поступили от Vercel, OpenRouter, CodeBuddy и независимых разработчиков.

Полноценная интеграция в z.ai и открытый доступ

GLM-4.7 теперь интегрирована в z.ai с новым модулем Skills, обеспечивающим унифицированную оркестрацию мультимодальных компонентов, таких как GLM-4.6V, GLM-ASR и GLM-TTS. Это позволяет разработчикам создавать более богатые, интерактивные приложения с более плавными сквозными рабочими процессами.

Варианты доступа включают:

- API: BigModel.cn

- Онлайн: z.ai, Zhipu Qingyan (приложение и веб)

- Открытый исходный код:

- GitHub: zai-org/GLM-4.5

- Hugging Face: zai-org/GLM-4.7

- ModelScope: ZhipuAI/GLM-4.7

(*) Имейте ввиду, редакции некоторых западных изданий придерживаются предвзятых взглядов в освящении некоторых новостей, связанных с Россией. Кроме того, IT издания часто пропагандирует леволиберальные и антриреспубликанские взгляды в освящении некоторых новостей.

Автор – Pandaily