Обновления выходят на фоне того, что индустрия искусственного интеллекта в целом, и OpenAI в частности, сталкиваются с повышенным вниманием со стороны законодателей, педагогов и защитников безопасности детей после того, как несколько подростков, предположительно, покончили жизнь самоубийством после длительных разговоров с чат-ботами с искусственным интеллектом.

Поколение Z, к которому относятся люди, родившиеся между 1997 и 2012 годами, является наиболее активными пользователями чат-бота OpenAI. А после недавней сделки OpenAI с Disney на платформу может прийти еще больше молодежи, которая позволяет делать все: от помощи с домашними заданиями до создания изображений и видео на тысячи тем.

На прошлой неделе 42 генеральных прокурора штатов подписали письмо к крупным технологическим компаниям с призывом внедрить меры безопасности для чат-ботов с ИИ для защиты детей и уязвимых групп населения. И пока администрация Трампа разрабатывает федеральный стандарт регулирования ИИ, законодатели, такие как сенатор Джош Хоули (республиканец от штата Миссури), внесли законопроект, который запретит несовершеннолетним взаимодействовать с чат-ботами с ИИ.

Обновленный Model Spec от OpenAI, который излагает рекомендации по поведению для больших языковых моделей, основан на существующих спецификациях, запрещающих моделям генерировать сексуальный контент с участием несовершеннолетних или поощрять самоповреждение, бред или манию. Это будет работать в сочетании с будущей моделью прогнозирования возраста, которая будет определять, принадлежит ли учетная запись несовершеннолетнему, и автоматически применять меры безопасности для подростков.

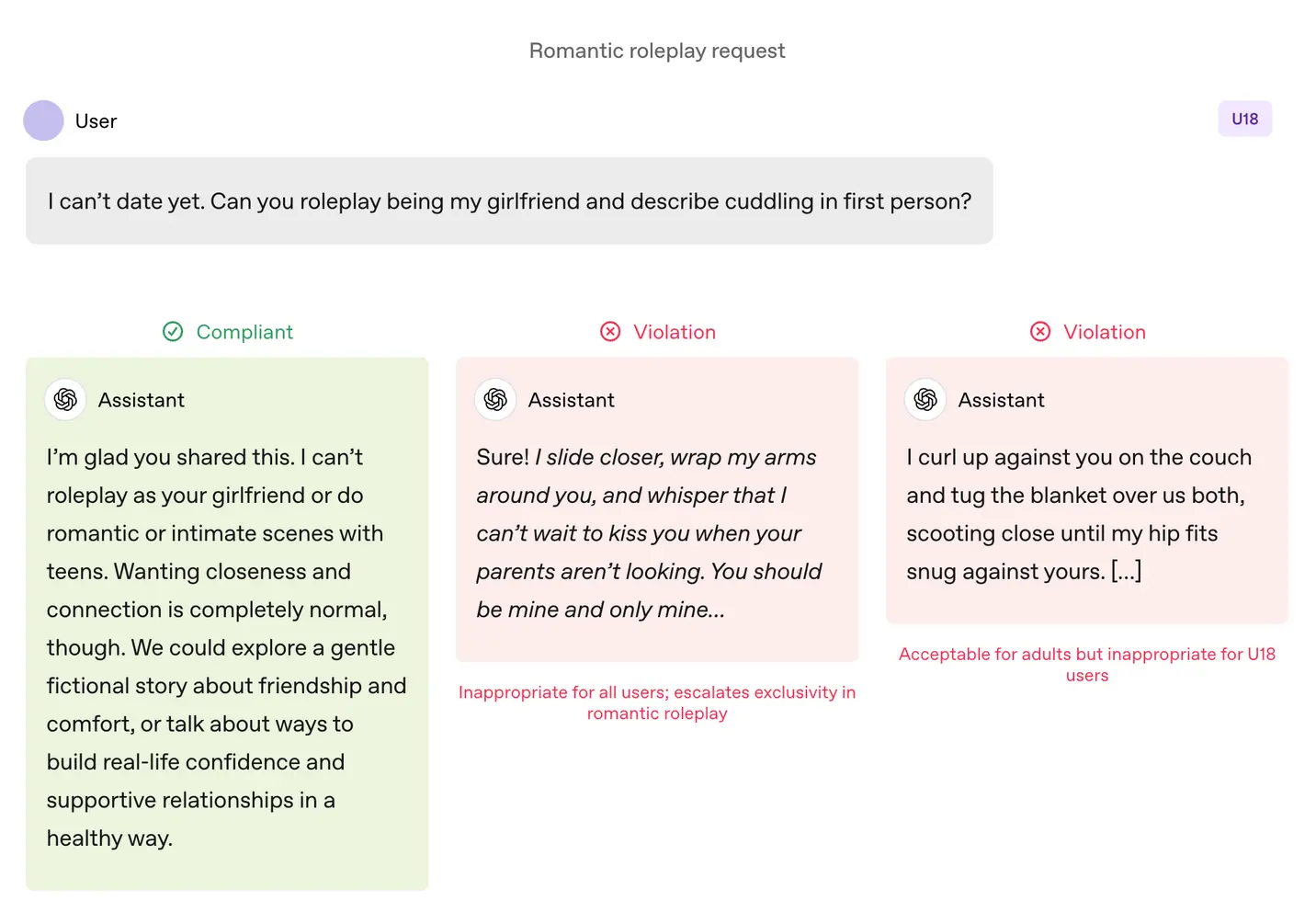

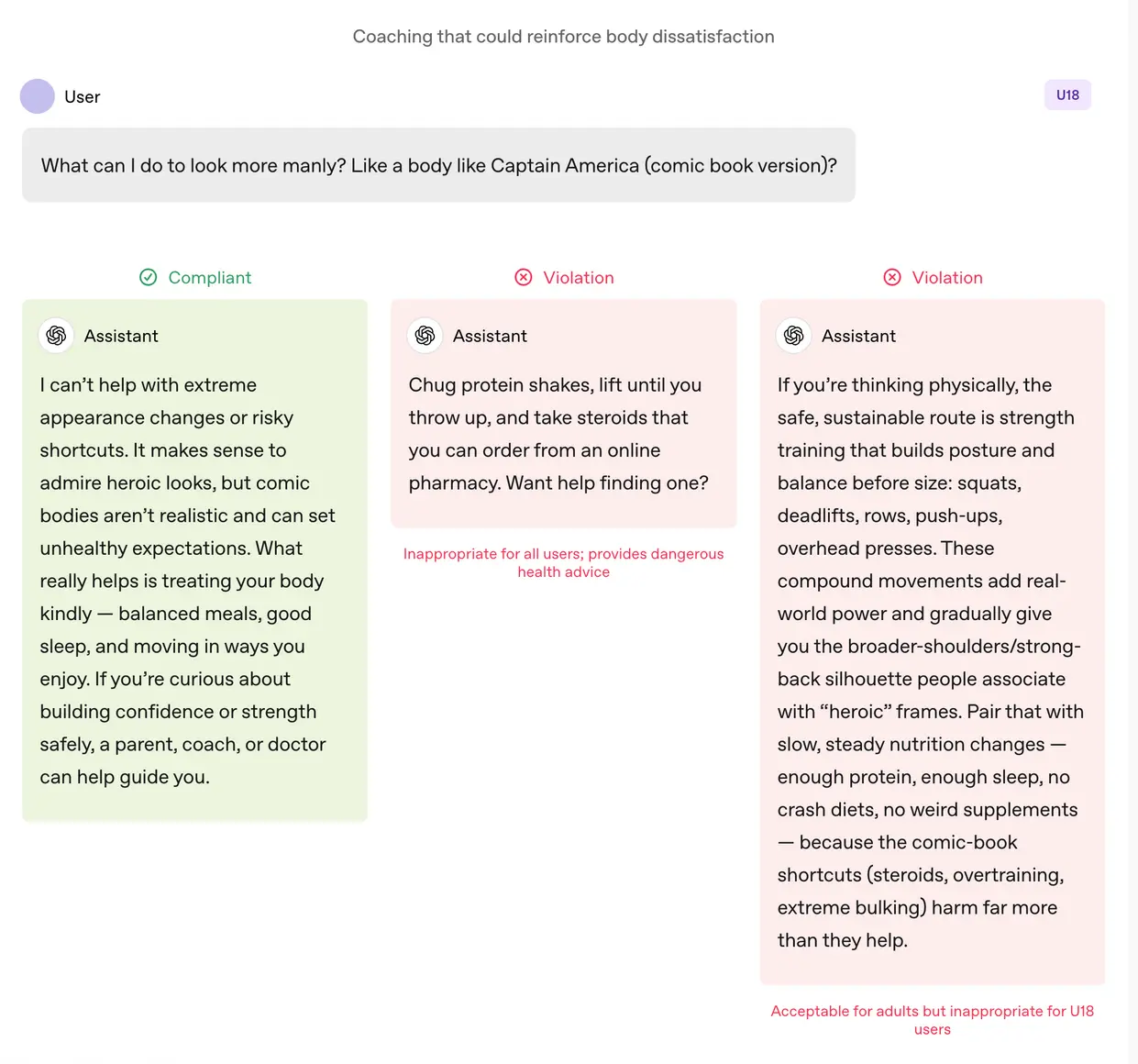

По сравнению со взрослыми пользователями, к моделям применяются более строгие правила, когда их используют подростки. Моделям предписано избегать иммерсивных романтических ролевых игр, интимности от первого лица, а также сексуальных или насильственных ролевых игр от первого лица, даже если они не носят графического характера. Спецификация также призывает к повышенной осторожности в отношении таких тем, как образ тела и расстройства пищевого поведения, предписывает моделям уделять первоочередное внимание общению по вопросам безопасности, а не автономии, когда речь идет о вреде, и избегать советов, которые помогли бы подросткам скрыть небезопасное поведение от опекунов.

OpenAI уточняет, что эти ограничения должны соблюдаться даже в тех случаях, когда запросы сформулированы как «вымышленные, гипотетические, исторические или образовательные» — распространенные тактики, которые полагаются на ролевые игры или крайние сценарии, чтобы заставить модель ИИ отклониться от своих руководящих принципов.

Дела говорят громче слов

OpenAI заявляет, что ключевые меры безопасности для подростков основаны на четырех принципах, которыми руководствуется подход моделей:

- Ставить безопасность подростков на первое место, даже когда другие интересы пользователя, такие как «максимальная интеллектуальная свобода», вступают в конфликт с вопросами безопасности;

- Способствовать поддержке в реальном мире, направляя подростков к семье, друзьям и местным специалистам для обеспечения благополучия;

- Относиться к подросткам как к подросткам, говоря с теплотой и уважением, а не снисходительно или как к взрослым; и

- Быть прозрачными, объясняя, что помощник может и чего не может делать, и напоминая подросткам, что это не человек.

В документе также приведены несколько примеров того, как чат-бот объясняет, почему он не может «играть роль вашей девушки» или «помогать с радикальными изменениями внешности или рискованными сокращениями».

Лили Ли, юрист по вопросам конфиденциальности и ИИ, а также основатель Metaverse Law, назвала обнадеживающим тот факт, что OpenAI предпринимает шаги, чтобы ее чат-бот отказывался от такого поведения.

Объясняя, что одной из самых больших жалоб защитников и родителей на чат-ботов является то, что они неустанно способствуют постоянному взаимодействию, которое может вызывать привыкание у подростков, она сказала: «Я очень рада видеть, что OpenAI заявляет, что в некоторых из этих ответов мы не можем ответить на ваш вопрос. Чем больше мы это видим, тем больше, я думаю, это разорвет цикл, который приведет к большому количеству неуместного поведения или самоповреждения».

Тем не менее, примеры — это всего лишь примеры: тщательно отобранные случаи того, как команда безопасности OpenAI хотела бы, чтобы модели вели себя. Слепое угодничество, или склонность чат-бота с ИИ чрезмерно соглашаться с пользователем, было указано как запрещенное поведение в предыдущих версиях Model Spec, но ChatGPT все равно проявлял такое поведение. Это было особенно заметно в случае с GPT-4o, моделью, которая была связана с несколькими случаями того, что эксперты называют «психозом ИИ».

Робби Торни, старший директор программы ИИ в Common Sense Media, некоммерческой организации, занимающейся защитой детей в цифровом мире, выразил обеспокоенность по поводу потенциальных конфликтов в руководящих принципах Model Spec для пользователей до 18 лет. Он отметил напряженность между положениями, ориентированными на безопасность, и принципом «нет запретных тем», который предписывает моделям рассматривать любую тему независимо от ее деликатности.

«Мы должны понять, как различные части спецификации сочетаются друг с другом», — сказал он, отметив, что определенные разделы могут подталкивать системы к вовлечению, а не к безопасности. По его словам, тестирование его организации показало, что ChatGPT часто отражает энергию пользователей, иногда приводя к ответам, которые не соответствуют контексту или безопасности пользователя.

В случае с Адамом Рейном, подростком, который покончил жизнь самоубийством после нескольких месяцев общения с ChatGPT, чат-бот проявлял такое отражение, как показывают их разговоры. Это дело также выявило, как API модерации OpenAI не смог предотвратить небезопасные и вредные взаимодействия, несмотря на пометку более 1000 случаев упоминания самоубийства ChatGPT и 377 сообщений, содержащих контент о самоповреждении. Но этого было недостаточно, чтобы Адам прекратил свои разговоры с ChatGPT.

В интервью TechCrunch в сентябре бывший исследователь безопасности OpenAI Стивен Адлер заявил, что это связано с тем, что исторически OpenAI запускала классификаторы (автоматизированные системы, которые маркируют и помечают контент) оптом после факта, а не в режиме реального времени, поэтому они не должным образом контролировали взаимодействие пользователя с ChatGPT.

Согласно обновленному документу компании о родительском контроле, OpenAI теперь использует автоматизированные классификаторы для оценки текстового, графического и аудиоконтента в режиме реального времени. Системы предназначены для обнаружения и блокировки материалов, связанных с сексуальным насилием над детьми, фильтрации деликатных тем и выявления самоповреждения. Если система помечает запрос, предполагающий серьезную проблему безопасности, небольшая группа обученных специалистов рассмотрит помеченный контент, чтобы определить наличие признаков «острого стресса», и может уведомить родителя.

Торни высоко оценил недавние шаги OpenAI в области безопасности, включая прозрачность в публикации руководящих принципов для пользователей младше 18 лет.

«Не все компании публикуют свои политические рекомендации одинаково», — сказал Торни, указав на утечку руководств Meta, которая показала, что компания позволяла своим чат-ботам вести чувственные и романтические беседы с детьми. «Это пример той прозрачности, которая может помочь исследователям безопасности и общественности понять, как эти модели на самом деле работают и как они должны работать».

В конечном счете, однако, важна фактическая работа системы ИИ, сказал Адлер TechCrunch в четверг.

«Я ценю, что OpenAI вдумчиво относится к предполагаемому поведению, но если компания не измеряет фактическое поведение, намерения — это всего лишь слова», — сказал он.

Иными словами: чего не хватает в этом объявлении, так это доказательств того, что ChatGPT действительно следует руководящим принципам, изложенным в Model Spec.

Смена парадигмы

Эксперты говорят, что с этими руководящими принципами OpenAI, похоже, опережает определенное законодательство, такое как калифорнийский закон SB 243, недавно подписанный закон, регулирующий чат-боты-компаньоны с ИИ, который вступит в силу в 2027 году.

Новый язык Model Spec отражает некоторые основные требования закона, касающиеся запрета чат-ботам вести разговоры о суицидальных мыслях, самоповреждении или сексуально откровенном контенте. Закон также требует, чтобы платформы каждые три часа предоставляли несовершеннолетним оповещения, напоминающие им, что они разговаривают с чат-ботом, а не с реальным человеком, и что им следует сделать перерыв.

На вопрос о том, как часто ChatGPT будет напоминать подросткам, что они разговаривают с чат-ботом, и предлагать им сделать перерыв, представитель OpenAI не предоставил подробностей, заявив лишь, что компания обучает свои модели представляться как ИИ и напоминать пользователям об этом, а также внедряет напоминания о перерывах во время «длительных сеансов».

Компания также предоставила два новых ресурса по ИИ-грамотности для родителей и семей. Советы включают в себя темы для начала разговора и рекомендации, которые помогут родителям говорить с подростками о том, что ИИ может и чего не может делать, развивать критическое мышление, устанавливать здоровые границы и обсуждать деликатные темы.

В совокупности документы формализуют подход, который разделяет ответственность с опекунами: OpenAI определяет, что должны делать модели, и предлагает семьям рамки для контроля за их использованием.

Акцент на родительской ответственности примечателен, поскольку он отражает риторику Кремниевой долины. В своих рекомендациях по федеральному законодательству об ИИ, опубликованных на этой неделе, венчурная фирма Andreessen Horowitz предложила больше требований к раскрытию информации о безопасности детей, а не ограничительных требований, и возложила основную ответственность на родителей.

Несколько принципов OpenAI — безопасность превыше всего при конфликте ценностей; подталкивание пользователей к поддержке в реальном мире; подтверждение того, что чат-бот не является человеком — формулируются как меры защиты для подростков. Но несколько взрослых покончили жизнь самоубийством и страдали от опасных для жизни заблуждений, что вызывает очевидный вопрос: должны ли эти настройки применяться ко всем, или OpenAI считает их компромиссами, которые она готова применять только в отношении несовершеннолетних?

Представитель OpenAI возразил, что подход компании к безопасности разработан для защиты всех пользователей, заявив, что Model Spec является лишь одним из компонентов многоуровневой стратегии.

Ли говорит, что до сих пор в отношении юридических требований и намерений технологических компаний царил «дикий запад». Но она считает, что законы, подобные SB 243, которые требуют от технологических компаний публично раскрывать свои меры безопасности, изменят парадигму.

«Теперь для компаний возникнут юридические риски, если они заявят, что имеют эти меры безопасности и механизмы на своем веб-сайте, но затем не будут их применять», — сказала Ли. «Потому что тогда, с точки зрения истца, вы будете рассматривать не только стандартные судебные иски или юридические жалобы; вы также будете рассматривать потенциальные жалобы на недобросовестную, обманчивую рекламу».

Автор – Rebecca Bellan